A função gaussiana

Thursday 16 August 2012 at 11:02 am

Versão para impressão

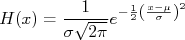

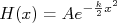

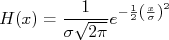

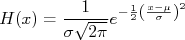

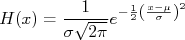

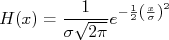

A função gaussiana é uma importante função de densidade de probabilidade, muito presente na física experimental. Ela tem a forma de um sino com a boca virado para baixo segundo a expressão:

Onde  corresponde ao desvio padrão da distribuição e

corresponde ao desvio padrão da distribuição e  , o seu valor médio. A figura 1 mostra a distribuição gaussiana.

, o seu valor médio. A figura 1 mostra a distribuição gaussiana.

Figura 1 - Função densidade de probabilidade gaussiana.

Por ser uma função densidade de probabilidade, a área entre dois limites da curva indica a probabilidade de encontrar a variável  entre esses limites. Em particular

entre esses limites. Em particular  pode assumir um valor entre

pode assumir um valor entre  e

e  com, aproximadamente, 68% de probabilidade.

com, aproximadamente, 68% de probabilidade.

Neste texto vamos mostrar algumas características da função gaussiana, o porque ela é tão presente na física experimental e uma maneira (dentre várias) de inferir a sua expressão matemática.

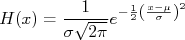

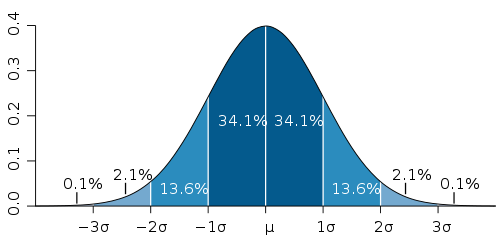

O Teorema do Limite Central

O Teorema do Limite Central é um dos teoremas fundamentais da teoria de probabilidade e, em linhas gerais pode ser enunciado como:

Em uma amostra aleatória qualquer simples  de elementos independentes entre si, com distribuições de probabilidade bem definida com variância

de elementos independentes entre si, com distribuições de probabilidade bem definida com variância  e média

e média  , na medida em que

, na medida em que  aumenta, a distribuição de probabilidades do valor médio dessa amostra aproxima-se de uma distribuição gaussiana de valor médio

aumenta, a distribuição de probabilidades do valor médio dessa amostra aproxima-se de uma distribuição gaussiana de valor médio  e variância

e variância  .

.

Esse teorema tem um grande impacto na física experimental em particular e explica porque a grande maioria das distribuições de grandezas experimentais apresentam uma distribuição gaussiana. Sabemos que toda medida tem um erro associado a ela. Esse erro é, em geral, composto da soma de um número muito grande de pequenos erros individuais, em geral, independentes. Por conta disso e, aplicando o teorema do limite central, a distribuição de probabilidade dessa medida experimental acaba seguindo uma distribuição gaussiana.

Esse teorema não é simples de ser provado no nível do curso de Física Experimental II. Mas para quem estiver interessado há uma demonstração formal neste link. Contudo, podemos fazer uma "demonstração" empírica a partir de um experimento virtual simples: jogar moedas.

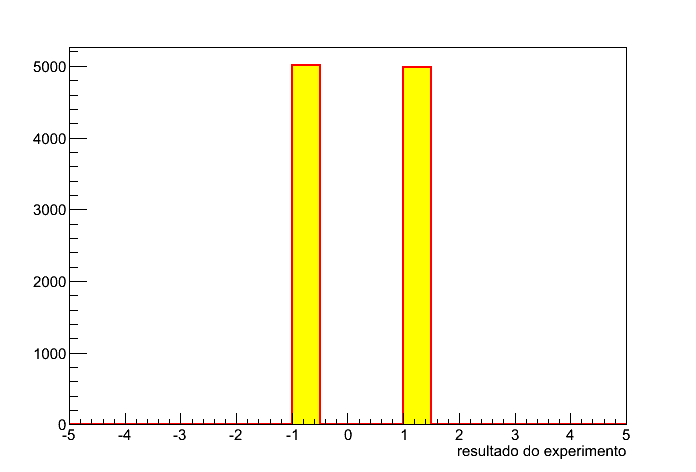

Uma moeda tem duas faces: cara e coroa. Para fins matemáticos, vamos assumir que cara tem valor 1 e coroa tem valor -1. Se jogarmos uma moeda, podemos obter cara ou coroa, ou seja, 1 ou -1. Para cada moeda jogada, verificamos qual face obtemos e preenchemos um histograma com o seu valor numérico (1 ou -1). Depois de repetir esse experimento 10000 vezes, obteremos aproximadamente 5000 vezes 1 e outras 5000 vezes, -1, conforme mostra a figura 2.

Figura 2 - Cara ou coroa.

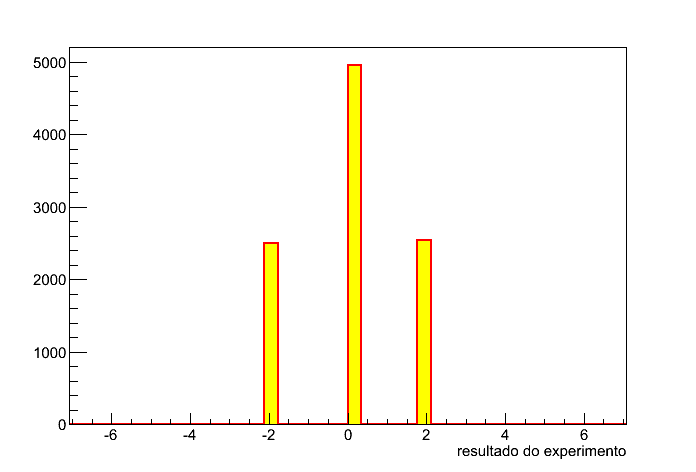

Agora vamos repetir o experimento mas, ao invés de jogar uma moeda, jogaremos duas e somaremos os resultados. Nesse caso, temos três valores possíveis, -2 (coroa+coroa), 0 (cara+ coroa ou coroa+cara) ou 2 (cara+cara), sendo 0 duas vezes mais provável que os demais. Repetindo o experimento 10000 vezes obtemos o resultado da figura 3.

Figura 3 - Duas moedas.

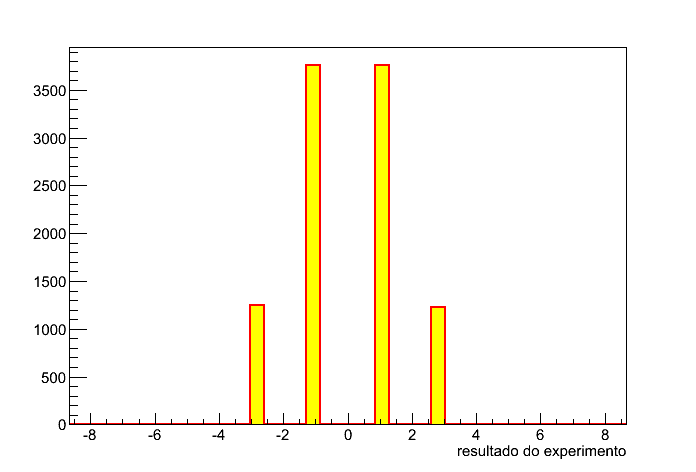

Jogando três moedas temos 4 possibilidades. Repetindo o experimento 10000 vezes obtemos o histograma da figura 4.

Figura 4 - Três moedas.

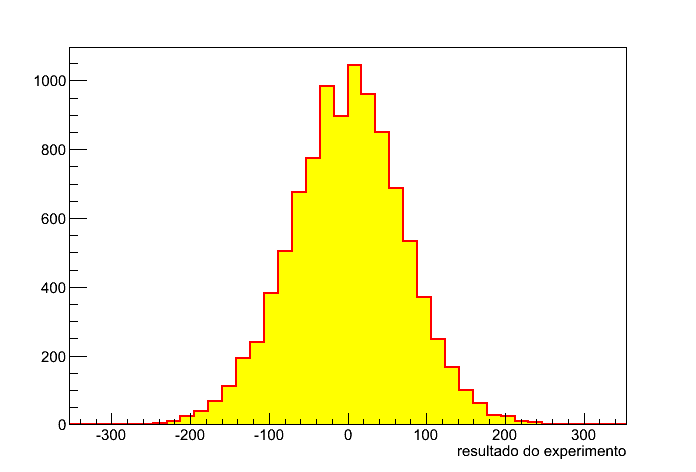

Você já percebeu onde vamos chegar. Imagine jogando um saco de 5000 moedas. Basicamente podemos obter valores entre -5000 e +5000, cada um com diferente probabilidade. Repetimos então esse experimento 10000 vezes. O resultado é mostrado na figura 5.

Figura 5 - 5000 moedas.

Obter como resultado o valor 5000 ou -5000 (todas moedas cara ou todas moedas coroa) é praticamente impossível. É muito mais provável obter metade cara e metade coroa, resultando em uma soma de valores nula. Note como a distribuição se assemelha a da figura 1, uma gaussiana. Isso é efeito do teorema do limite central onde temos várias grandezas aleatórias sendo somadas de forma independente. O engraçado disso é que o resultado não depende da distribuição de cada grandeza. Tanto faz se temos uma distribuição com duas possibilidades (cara e coroa) ou muitas possibilidades. O resultado é sempre uma gaussiana.

Inferência da expressão da distribuição Gaussiana

Há alguns anos eu topei com uma dedução da expressão para a gaussiana a partir de princípios muito simples. Eu não encontrei mais a referência (se alguém descobrir me avise) então resolvi reproduzir esta dedução aqui. Acredito que esta não é uma dedução muito formal como a que encontramos em geral em livros de estatística e sim uma forma de inferir a fórmula da gaussiana a partir de um experimento imaginário simples. Uma dedução mais formal, onde fica claro o teorema do limite central, pode ser encontrada no livro Tratamento Estatístico de Dados em Física Experimental, do Otaviano Helene e Vito Vanin, no capítulo IV.

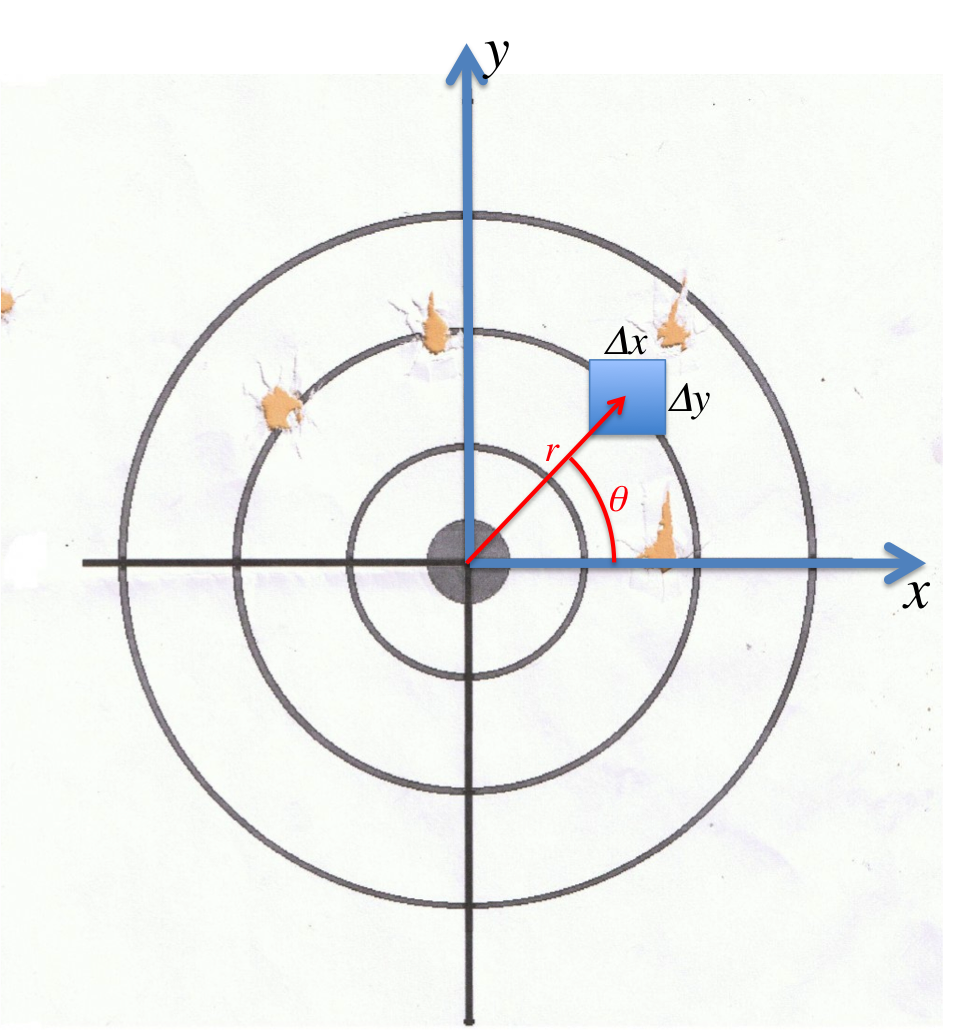

Vamos partir de princípios simples, tentando imaginar um experimento que consiste em atirar flechas contra um alvo. A mosca deste alvo é a origem de um plano cartesiano x-y. Contudo, por conta da precisão do arqueiro, nem sempre se consegue acertar a mosca. Vamos assumir que:

- Não há problemas de acurácia, ou seja, o arqueiro, em média, acerta a mosca.

- Acertar longe da mosca é menos provável que acertar perto.

- Os erros da posição que a flecha atinge o alvo são independentes, ou seja, uma boa precisão na posição no eixo x não significa uma boa precisão no eixo y, e vice-versa.

- Os erros da posição que a flecha atinge o alvo não dependem da orientação do plano cartesiano. Isto é, tanto faz qual é a direção e sentido dos eixos x e y.

Um esquema desse experimento imaginário é mostrado na figura 6.

Figura 6 - Esquema do experimento imaginário do artirador, bem como representação de grandezas utilizadas no texto.

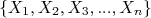

A probabilidade de o atirador acertar uma certa posição do alvo entre  e

e  pode ser calculada a partir da função densidade de probabilidade em

pode ser calculada a partir da função densidade de probabilidade em  ,

,  e vale

e vale  , desde que

, desde que  não varie muito no intervalo

não varie muito no intervalo  . O mesmo pode ser aplicado ao eixo y e a probabilidade de acertar uma região entre

. O mesmo pode ser aplicado ao eixo y e a probabilidade de acertar uma região entre  e

e  é

é  .

.

Deste modo, a probabilidade de acertar uma pequena região quadrada do alvo, de larguras  e

e  , na posição

, na posição  em relação à origem é o produto das duas probabilidades, já que os erros em cada eixo são independentes, ou seja,

em relação à origem é o produto das duas probabilidades, já que os erros em cada eixo são independentes, ou seja,  .

.

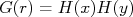

O produto  corresponde à função densidade de probabilidade de acertar a posição

corresponde à função densidade de probabilidade de acertar a posição  e depende somente da distância à origem, uma vez que a orientação dos eixos cartesianos não afeta a probabilidade final do arqueiro acertar uma posição do alvo. Sendo assim, eu posso orientar esses eixos em qualquer direção. Uma rotação qualquer desses eixos em torno da origem por um ângulo

e depende somente da distância à origem, uma vez que a orientação dos eixos cartesianos não afeta a probabilidade final do arqueiro acertar uma posição do alvo. Sendo assim, eu posso orientar esses eixos em qualquer direção. Uma rotação qualquer desses eixos em torno da origem por um ângulo  qualquer não deve mudar o valor de

qualquer não deve mudar o valor de  . Isso significa que:

. Isso significa que:

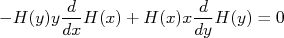

Vamos então calcular essa derivada:

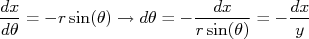

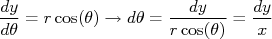

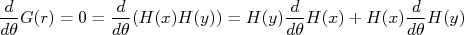

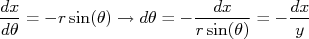

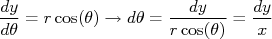

Manter o ângulo nessa expressão não é interessante, já que queremos obter as densidades de probabilidade em x e y. Sabemos que a conversão de coordenadas  , cartesiana, para

, cartesiana, para  , polares, é bastante simples, ou seja:

, polares, é bastante simples, ou seja:

De modo que:

Substituindo isso na expressão para a derivada de  em

em  obtem-se que:

obtem-se que:

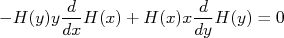

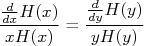

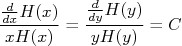

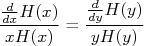

Isolando tudo que vem de x de um lado da equação e tudo de y do outro lado, chega-se à:

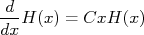

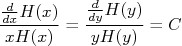

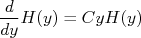

O interessante desta equação é que a única forma dela ser verdadeira é se os termos da direita e esquerda não dependerem mais de y e x, ou seja, forem constantes. Deste modo:

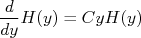

Onde  é uma constante. Portanto, para achar

é uma constante. Portanto, para achar  e

e  devemos resolver as equações:

devemos resolver as equações:

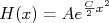

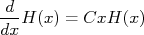

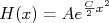

Estas equações diferenciais são simples de resolver e têm como solução (aplique essas solução e veja você mesmo), no caso para x:

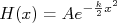

A solução para y é equivalente. A constante  deve ser negativa pois a probabilidade deve diminuir na medida em que x (ou y) aumenta. Deste modo podemos reescrever a expressão acima como:

deve ser negativa pois a probabilidade deve diminuir na medida em que x (ou y) aumenta. Deste modo podemos reescrever a expressão acima como:

onde  . Precisamos agora determinar quanto vale

. Precisamos agora determinar quanto vale  e

e  . O valor de

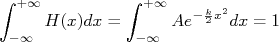

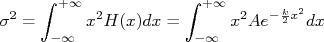

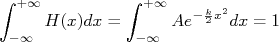

. O valor de  é facilmente determinado sabendo-se que a integral da função densidade de probabilidade em todo espaço vale 1. Assim:

é facilmente determinado sabendo-se que a integral da função densidade de probabilidade em todo espaço vale 1. Assim:

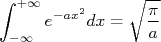

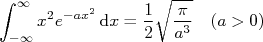

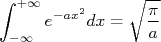

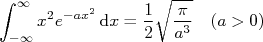

Consultando uma boa tabela de integrais, é fácil encontrar que:

Por comparação e igualando à 1, é fácil ver que:

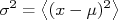

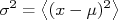

Resta-nos agora determinar o valor de  . Podemos fazer isso através da definição de variância:

. Podemos fazer isso através da definição de variância:

onde  é o valor verdadeiro de uma grandeza. No nosso caso é zero, já que a mosca está posicionada na origem do nosso sistema cartesiano. Para uma distribuição contínua de possibilidades, a média acima é escrita em termos da função densidade de probabilidade como:

é o valor verdadeiro de uma grandeza. No nosso caso é zero, já que a mosca está posicionada na origem do nosso sistema cartesiano. Para uma distribuição contínua de possibilidades, a média acima é escrita em termos da função densidade de probabilidade como:

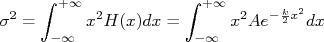

Consultando uma boa tabela de integrais, também encontramos que:

Aplicando essa expressão no cálculo da variância chegamos que:

Ou seja, substituindo  e

e  na expressão para

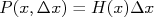

na expressão para  chegamos, finalmente, à:

chegamos, finalmente, à:

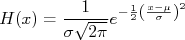

Que é a expressão da função densidade de probabilidade gaussiana, ou normal, com valor verdadeiro zero e desvio padrão  . A generalização para valor verdadeiro (

. A generalização para valor verdadeiro ( ) diferente de zero corresponde somente a uma translação da origem do eixo no plano cartesiano por esse valor, ou seja:

) diferente de zero corresponde somente a uma translação da origem do eixo no plano cartesiano por esse valor, ou seja:

corresponde ao desvio padrão da distribuição e

corresponde ao desvio padrão da distribuição e  , o seu valor médio. A figura 1 mostra a distribuição gaussiana.

, o seu valor médio. A figura 1 mostra a distribuição gaussiana.

entre esses limites. Em particular

entre esses limites. Em particular  pode assumir um valor entre

pode assumir um valor entre  e

e  com, aproximadamente, 68% de probabilidade.

com, aproximadamente, 68% de probabilidade. de elementos independentes entre si, com distribuições de probabilidade bem definida com variância

de elementos independentes entre si, com distribuições de probabilidade bem definida com variância  e média

e média  , na medida em que

, na medida em que  aumenta, a distribuição de probabilidades do valor médio dessa amostra aproxima-se de uma distribuição gaussiana de valor médio

aumenta, a distribuição de probabilidades do valor médio dessa amostra aproxima-se de uma distribuição gaussiana de valor médio  e variância

e variância  .

.

e

e  pode ser calculada a partir da função densidade de probabilidade em

pode ser calculada a partir da função densidade de probabilidade em  ,

,  e vale

e vale  , desde que

, desde que  não varie muito no intervalo

não varie muito no intervalo  . O mesmo pode ser aplicado ao eixo y e a probabilidade de acertar uma região entre

. O mesmo pode ser aplicado ao eixo y e a probabilidade de acertar uma região entre  e

e  é

é  .

.

e

e  , na posição

, na posição  em relação à origem é o produto das duas probabilidades, já que os erros em cada eixo são independentes, ou seja,

em relação à origem é o produto das duas probabilidades, já que os erros em cada eixo são independentes, ou seja,  .

.

corresponde à função densidade de probabilidade de acertar a posição

corresponde à função densidade de probabilidade de acertar a posição  e depende somente da distância à origem, uma vez que a orientação dos eixos cartesianos não afeta a probabilidade final do arqueiro acertar uma posição do alvo. Sendo assim, eu posso orientar esses eixos em qualquer direção. Uma rotação qualquer desses eixos em torno da origem por um ângulo

e depende somente da distância à origem, uma vez que a orientação dos eixos cartesianos não afeta a probabilidade final do arqueiro acertar uma posição do alvo. Sendo assim, eu posso orientar esses eixos em qualquer direção. Uma rotação qualquer desses eixos em torno da origem por um ângulo  qualquer não deve mudar o valor de

qualquer não deve mudar o valor de  . Isso significa que:

. Isso significa que:

, cartesiana, para

, cartesiana, para  , polares, é bastante simples, ou seja:

, polares, é bastante simples, ou seja:

em

em  obtem-se que:

obtem-se que:

é uma constante. Portanto, para achar

é uma constante. Portanto, para achar  e

e  devemos resolver as equações:

devemos resolver as equações:

deve ser negativa pois a probabilidade deve diminuir na medida em que x (ou y) aumenta. Deste modo podemos reescrever a expressão acima como:

deve ser negativa pois a probabilidade deve diminuir na medida em que x (ou y) aumenta. Deste modo podemos reescrever a expressão acima como:

. Precisamos agora determinar quanto vale

. Precisamos agora determinar quanto vale  e

e  . O valor de

. O valor de  é facilmente determinado sabendo-se que a integral da função densidade de probabilidade em todo espaço vale 1. Assim:

é facilmente determinado sabendo-se que a integral da função densidade de probabilidade em todo espaço vale 1. Assim:

. Podemos fazer isso através da definição de variância:

. Podemos fazer isso através da definição de variância:

é o valor verdadeiro de uma grandeza. No nosso caso é zero, já que a mosca está posicionada na origem do nosso sistema cartesiano. Para uma distribuição contínua de possibilidades, a média acima é escrita em termos da função densidade de probabilidade como:

é o valor verdadeiro de uma grandeza. No nosso caso é zero, já que a mosca está posicionada na origem do nosso sistema cartesiano. Para uma distribuição contínua de possibilidades, a média acima é escrita em termos da função densidade de probabilidade como:

e

e  na expressão para

na expressão para  chegamos, finalmente, à:

chegamos, finalmente, à:

. A generalização para valor verdadeiro (

. A generalização para valor verdadeiro ( ) diferente de zero corresponde somente a uma translação da origem do eixo no plano cartesiano por esse valor, ou seja:

) diferente de zero corresponde somente a uma translação da origem do eixo no plano cartesiano por esse valor, ou seja: